In wenigen Schritten zur eigenen KI auf dem heimischen Computer. Vorgestellt wird Ollama und die schrittweise Installation unter Windows.

Das Thema Künstliche Intelligenz (KI) ist aktuell in allen Medien und es gibt monatlich wenn nicht sogar wöchentlich neue Berichte über weitere Verbesserungen und die nächste Generation mit mehr Funktionen. Doch was ist KI? Ist das nur irgendeine Webseite im Internet auf der Text eingegeben kann und die einem Antworten liefert? Teilweise schon, aber das ganze lässt sich auch zu Hause auf dem eigenen Computer betreiben.

Hardware

Wir haben Zugriff auf einen einfachen PC, der so auch zum Spielen genutzt werden kann.

| Komponente | Eigenschaft |

|---|---|

| CPU | AMD Ryzen 5 5600X |

| RAM | 32 GB |

| Datenträger | SSD |

| GPU | NVIDIA GeForce RTX 4060 8 GB |

Als Betriebssystem kommt das für den Arbeitseinsatz installierte Windows 11 zum Einsatz.

Installation

Die Ollama Anwendung wird in der aktuellen Version unter der MIT Lizenz veröffentlicht und ist somit Open Source. Die Anwendung kann direkt über die Webseite für https://ollama.com/download für Linux, Windows und MacOS heruntergeladen werden.

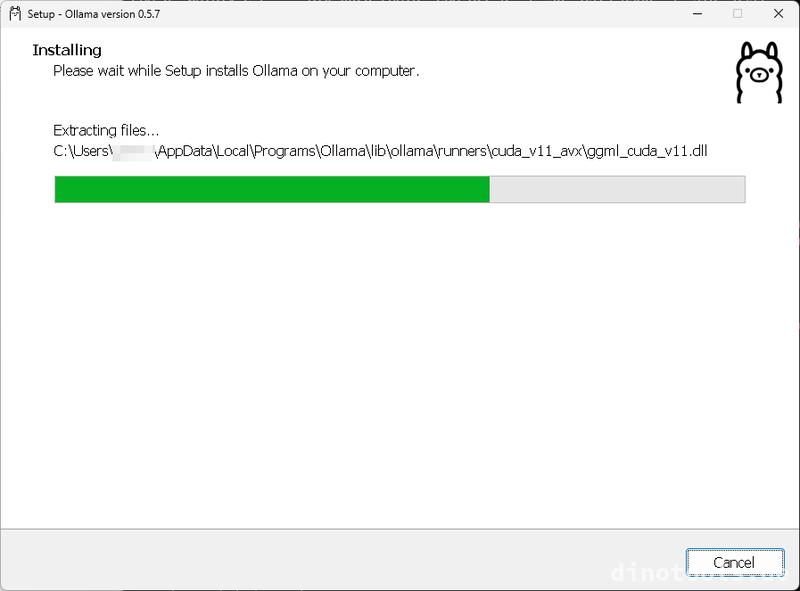

Heruntergeladen wurde die Datei OllamaSetup.exe. Diese kann gestartet werden und ein Installationsfenster sollte sich öffnen. Die Installation bietet keine weiteren Optionen. Für die Installation werden keine besonderen Berechtigungen benötigt, da die Anwendung standardmäßig in das Benutzerverzeichnis installiert wird.

Ort für Modelle festlegen

Einfache Modelle sind meistens nur ein paar Gigabyte groß. Es gibt aber auch Modelle, die je nach Art mehrere hundert Gigabyte groß sein können. Daher bietet es sich an diese Modelle auf ein extra Laufwerk oder zumindest in ein extra Verzeichnis zu legen.

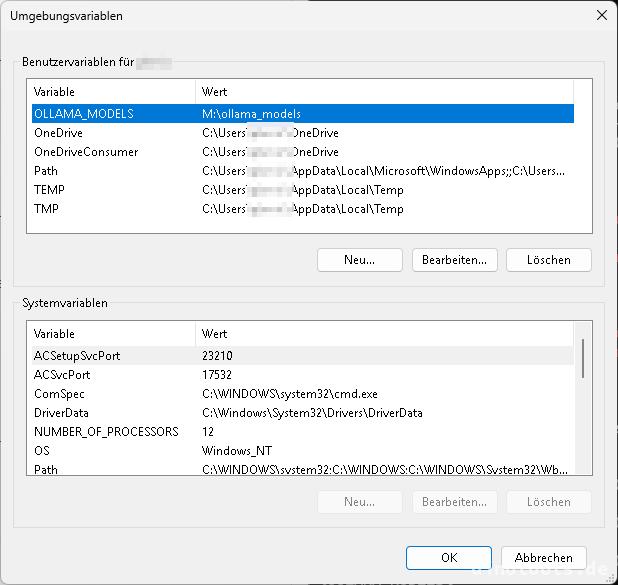

Der Speicherort für Modelle kann über die Umgebungsvariable OLLAMA_MODELS festgelegt werden.

Im Windows-Menü nach "Umgebungsvariable für dieses Konto bearbeiten" suchen und dort unter "Benutzervariablen für ..." die entsprechende Variable und den Pfad hinterlegen.

Ist die Variable gesetzt, kann zum Beispiel über eine neue Powershell Sitzung geprüft werden, ob sie auch richtig übernommen wurde.

PS C:\Users\user> echo $Env:OLLAMA_MODELS

M:\ollama_models

Ist die Variable wie gewünscht gesetzt, muss Ollama neu gestartet werden. Das Beenden kann über das Try-Icon erfolgen.

Und der Start erfolgt über den Eintrag "Ollama" im Windows-Menü.

Erste Schritte

In einer Powershell Sitzung können erste Test gemacht werden. So zeugt der folgende Befehl an, dass aktuell kein Model aktiv ist und läuft.

PS C:\Users\user> ollama.exe ps

NAME ID SIZE PROCESSOR UNTIL

Der nächste Befehl zeigt eine Liste der heruntergeladenen und installieren Modelle an.

PS C:\Users\user> ollama.exe list

NAME ID SIZE MODIFIED

Da noch kein Model vorhanden ist, kann das erste wie folgt heruntergeladen und direkt ausgeführt werden. In diesem Fall wird llama3.2 verwendet. Dieses wird aktuell in vielen Beispielen verwendet und ist mit einer Downloadgröße von ca. 2GB nicht sehr groß für einen ersten test. Ist der Download beendet, wechselt ollama direkt in einen interaktiven Prompt in dem mit dem Model kommuniziert werden kann.

PS C:\Users\user> ollama run llama3.2

pulling manifest

pulling dde5aa3fc5ff... 100% ▕██████████████████████████████████████▏ 2.0 GB

pulling 966de95ca8a6... 100% ▕██████████████████████████████████████▏ 1.4 KB

pulling fcc5a6bec9da... 100% ▕██████████████████████████████████████▏ 7.7 KB

pulling a70ff7e570d9... 100% ▕██████████████████████████████████████▏ 6.0 KB

pulling 56bb8bd477a5... 100% ▕██████████████████████████████████████▏ 96 B

pulling 34bb5ab01051... 100% ▕██████████████████████████████████████▏ 561 B

verifying sha256 digest

writing manifest

success

>>> Send a message (/? for help)

>>> /?

Available Commands:

/set Set session variables

/show Show model information

/load <model> Load a session or model

/save <model> Save your current session

/clear Clear session context

/bye Exit

/?, /help Help for a command

/? shortcuts Help for keyboard shortcuts

Use """ to begin a multi-line message.

Weitere Modelle

Das Ollama Projekt stellt eine Webseite mit einer Suche bereit auf der die Verschiedensten verfügbaren Modelle aufgelistet sind. Zusätzlich gibt es Informationen zu den einzelnen Modellen und es können teilweise auch weitere Arten heruntergeladen werden.

Links

- Webseite: Ollama (englisch)

- Webseite: Ollama Model Suche (englisch)